Ensembles

Beschreibung

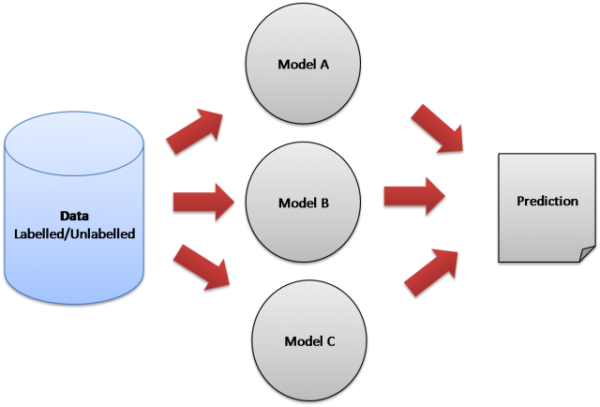

Da meist ein Klassifikator bei einer Klassifikation nicht das optimale Ergebnis liefert, gibt es die Möglichkeit verschiedene Klassifikatoren zu Ensembles zu kombinieren. Durch diese Kombination einzelner Klassifikatoren sollen die Schwächen jedes Klassifikators ausgeglichen werden.

Theorie

Zur Erzeugung eines Satzes von Klassifikatoren gibt es verschiedene Möglichkeiten. Es können variiert werden:

- der Klassifikatortyp: Neuronale Netze, SVMs, Statistische Klassifkatoren, etc.

- die Klassifikatorparameter: Anzahl verborgener Schichten bei NNs, Anzahl Neuronen pro Schicht, Initialwerte, Lernrate, Auswahl bestimmter Merkmale, Abbruchkriterium, etc.

- die Trainingsdaten: Aufteilen der Stichprobe: Bagging, Gewichtung der Samples: Boosting

In der Praxis werden heute schon Ensembles, z.B. Random Forest (Bagging mit Decision Trees), eingesetzt.

Vor- und Nachteile des Algorithmus

Vorteile:

- + Große Anzahl von möglichen Kombinationen.

- + Kombinationen können Zielgerichtet angepasst werden.

Nachteile:

- - Ensembles können aufgrund ihrer Komplexität schwieriger zu interpretieren sein.